Category:情報理論

ファノの不等式

Fano's inequality

エントロピーレート

Entropy rate

エルウィン・バーレカンプ

Elwyn Berlekamp

レイ・ソロモノフ

Ray Solomonoff

ウラジーミル・レーベンシュタイン

Vladimir Levenshtein

二値エントロピー関数

Binary entropy function

傾向推定

Linear trend estimation

二分バンド幅

Bisection bandwidth

符号化率

ロブ・クリング

Rob Kling

Common data model

Common data model

エントロピー不確定性

Entropic uncertainty

冗長性 (情報理論)

Redundancy (information theory)

情報源レート

ソロモン・ゴロム

Solomon W. Golomb

バーレカンプ–ウェルチアルゴリズム

Berlekamp–Welch algorithm

ロバート・ファノ

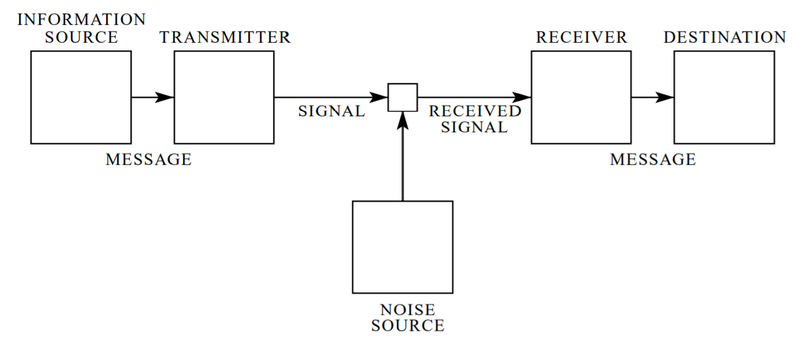

Robert Fano通信の数学的理論

A Mathematical Theory of Communication

ラルフ・ハートレー

Ralph Hartley

クロード・E・シャノン賞

Claude E. Shannon Award

グレゴリー・チャイティン

Gregory Chaitin

リチャード・ハミング

Richard Hamming

符号レート

Code rate

位相因子

Phase factor

ランダウアーの原理

Landauer's principle

スペクトル効率

Spectral efficiency

結合エントロピー

Joint entropy

ギブスの不等式

Gibbs' inequality